AI新知力系列

統計學本質和架構筆記 - 106你的統計分析三套件上線了

上一篇筆記說到無母數的出現就是有母數是基於常態分配假設下而生。只要母體參數不是常態分配的平均數和變異數參數,都歸類去無母數分析方法處理。如果能解決一開始就找出統計量抽樣分配的問題,那麼統計分析三套件照樣可以執行。

如果你還沒看過前5篇筆記,可以先複習一下喔。

101《認識統計學的兩大板塊》

102《了解統計學兩大板塊關係》

103《機率分配參數代表母體特性》

105《無母數可以變成有母數》

1. 點估計

想了解點估計需要分兩點說明。

- 點估計量:是數學函數,可以是樣本的各種數學組合

- 點估計值:由隨機樣本根據點估計量的數學函數,計算出點估計值

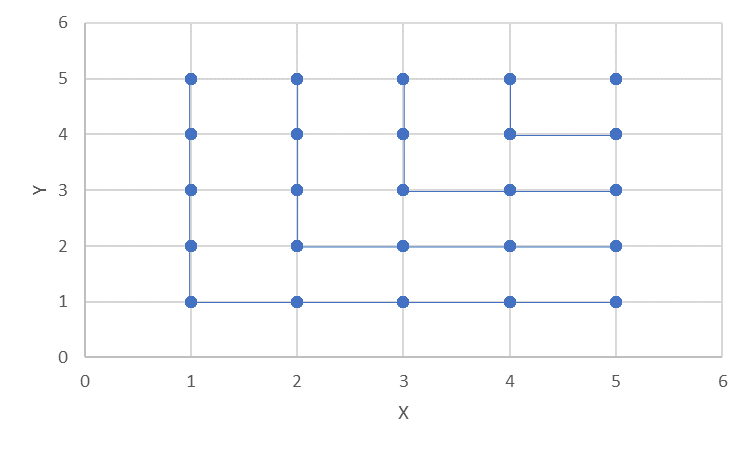

點估計量需要符合上圖的充分、不偏、效率、一致性。而找點估計量方法常見的是最大概似法(高中數學有教)、最小平方法(BLUE迴歸方法所用,高中數學有教)、UMVUE(滿足不偏和效率性)、動差法(MM,很好用,但未必滿足點估計量該有的特性)。

點估計量要滿足充分、不偏、效率、一致性。

-

充分性:

點估計量可以充分反映母體參數對樣本的影響。例如均勻分配的參數就是最大最小值,所以我們得從抽出來的樣本中,找出最大和最小值。而點估計量就是max和min函數。你會想這是什麼呢?有學過經濟學的朋友們可以了解一下里昂鐵夫函數(最小值函數)。一般的朋友可以了解一下在二維平面畫L或┐。

-

不偏性:點估計量的平均數(統計學上稱為期望值)和母體參數一樣,也就是偏誤值=0。

-

效率性:這是很難做到的!也就是在所有充分統計量中要選擇變動程度最小的那個點估計量。如果點估計量是充分統計量且具有不偏性就具有最小變異程度。

-

一致性:點估計量隨著抽樣的樣本個數增加,會趨近母體參數值。

一般在驗證這項特性時喜歡用財比雪夫公式,或者是第三點的變異程度因樣本個數增加而趨近0,就能稱點估計量趨近母體參數。另外,如果使用第二點特性的偏差,因樣本個數增加而趨近0,稱為趨近不偏性。

第1點是最難的。當你母體是什麼都不知道時,怎麼會知道母體參數呢?通常點估計量的充分性很難去評估。

第二點和第三點分別是一階動差和二階動差,最容易理解的方式就是平均數和變異數。你也可以想像是從函數的一次方和二次方形式。一次方通常都是線,二次方就會有圓、拋物線之類的。

第三點的效率性影響到區間估計的區間範圍是否達到最小。我得說就我看到一些論文在寫他們的統計量的區間估計公式時,光是效率性都模糊帶過。我特別指出母體不是常態分配的情況下,單一個變異數的抽樣分配是什麼,怎麼保證區間估計的範圍是最小?這在文獻上有人研究,並且數學推導極其簡略(因為數學證明不出來,要用隨機數字)。在《Excel calculating the probability distribution simulated data》就能很快速用數字幫助你解決前述的問題,並且在分配下對應出最小區間。

第四點的一致性就和中央極限定理、大數法則有關。也就是因為第四點才會讓常態分配貫穿整個統計分析。

2. 區間估計

因為點估計量在樣本代入後只剩一個數字,讓人害怕,所以考慮隨機性,就給它上多次抽樣程序,形成風險考慮。而不是板上釘釘的一個數字代表全體數字。 區間估計,顧名思義就是有個範圍。這個範圍的產生來自你平均n次的抽樣,每次抽m個樣本所產生的範圍區間。那麼m個樣本的平均數或變異數就會有一定比例落在此區間內。

重點來了~~~

-

區間估計是事前概念。如果你已經抽出m個樣本,算出來的平均數或變異數,只有成功或失敗的結果,也就是是否在區間內的結果,沒有什麼可能性的情況。

-

上述的比例是人為設定。你喜歡90%、95%、99%、99.9%都可以。這個比例稱為信賴水準,代表平均100次有多少次的平均數或變異數會落在這個區間範圍。

-

撐出區間範圍稱為最大誤差,是靠變異數撐的,也就是點估計量的第三點特性 - 效率性。

| 用公式表示:P( | Z | ≤ Z(α/2)) 1- α,於是上方的2和3點就能對應出下面的三點。 |

-

( 1-α ) * 100%就是上述第二點

-

Z叫做標準化,數值扣除平均數後,除以標準差(這裡的標準差是指抽樣分配的標準差)

-

Z(α/2)通常指標準常態分配的臨界值。如果你能找出統計量的抽樣分配,自然也能將標準常態分配給踢掉,變成特定分配的臨界值

你移項後,區間估計的重點是母體平均數和母體變異數,所以放在區間不等式中間。也就是說你是用樣本在找母體平均數或母體變異數的區間範圍。

3. 假設檢定

都到了區間估計了,一個數字怕代表性不夠,那就多次試驗,產生隨機性,成為有考慮風險,提高對這個點估計值的信任度。但這樣還不夠!誰叫區間估計太難評判了。最好可以有方便點的,直接點的,就跟我說是這樣,不是這樣。多棒啊~~

於是假設檢定就來啦!加入判斷。人工智慧不也需要判斷嗎?就此而引入。

假設檢定分成4個部份:假設、檢定、顯著水準、判斷準則。

-

假設:統計學的哲學觀,以二分法形式出現虛無假設和對立假設。你認定為真的放對立假設,以較為嚴格的態度去檢定它。有等號的虛無假設擁有灰色地帶,也就是更多的話語權。只要你沒有顯著的證據可以拒絕掉虛無假設,那虛無假設就是成立的。

-

顯著水準:這是人為設定的機率值。對應到區間估計的信賴水準,兩者相加為1。所以顯著水準指的就是在那麼寬的信賴水準下,你還會落到極端,那就可以稱之為顯著的證據了。

不過也有可能會犯錯!顯著水準本身就是犯錯機率的一種。它是指在虛無假設為真的情況下,你還拒絕了虛無假設的機率。這個顯著水準的機率值愈小,表示我們對虛無假設愈寬容,也意味著檢定愈發嚴格。一旦真是有顯著證據可以證明,那就表示結果愈發可靠。

從顯著水準的犯錯機率就會找出另一個犯錯機率,那就是對立假設是真,但你卻接受虛無假設的機率。這個機率值衍生出作業曲線,再到醫療品質和臨床篩檢的ROC。

-

檢定:其實檢定公式和區間估計一樣。差異在於這時候的母體參數不是未知的,而是你認定的虛無假設值。

-

判斷準則:因為第二點的確定,使得抽樣分配可以二分出「拒絕域」和「非拒絕域」。然後你再比對檢定公式計算出來的數字落在哪。

這裡的前提很多是人為認定的。所以在人工智慧的發展上也有這樣的情況。其實假設檢定中人為認定的部份是可以改變的,就如同我們對序列相關的Durbin-Watson 檢定的數字就不一定是0。你可以設定-0.9, -0.8, -0.5, 0.2, 0.4, 0.8等,只要符合統計量要求的數字都能做檢定。真實情況是在沒有《Demythologize Durbin-Watson Test Statistic》出來前,真的就只檢定有無序列相關。另一個就是檢定是不是1(單根檢定),表示是不是前一期完全影響當期。

結語

今天的統計分析三套件就分享到這。後二者需要先有統計量和抽樣分配後才能進行。另外也在結語的地方歸納換湯不換藥的統計量名詞。

統計分析的統計量

點估計:統計量/估計量

區間估計:估計量

假設檢定:檢定量

其實都是指統計量,這個由樣本產生的數學組合函數。